公告:如需购买GPT帐号或代充值GPT4(plus)会员,请添加站长微信:gptchongzhi

什么是图灵测试? 通过图灵测试重要性和局限性? AI应用和开发现状和问题?

推荐使用GPT中文版,国内可直接访问:https://ai.gpt86.top

图灵测试

01 什么是图灵测试?

测试包括一个人类评估者与另外两个参与者进行自然语言对话,其中一个是人类,另一个是机器。

评估者不知道参与者是机器还是人类。

评估者需要判别哪个参与者是机器还是人类。

如果评估者不能一致地区分这两个参与者,并且如果机器让评估者做出超过30%的误判。那么机器就被认为通过了图灵测试,展示出类人的智能。

图灵测试经常被用作评估人工智能研究进展的基准。

02 通过图灵测试第一个案例

图灵测试重要性和局限性

01 通过图灵测试的意义

证明人工智能的智能水平:如果一个AI模型能够通过图灵测试,这表明它能够表现出足以欺骗人类的智能和行为。这可能会改变人们对于人工智能的认识和对其智能水平的评估。

提高自然语言处理的质量:通过图灵测试的AI模型可能具有更好的自然语言处理能力,能够更好地理解人类的语言和表达方式。这可能会带来更好的聊天机器人、虚拟助手和语言翻译等应用。

促进人机交互的发展:通过图灵测试的AI模型能够更好地与人类进行交互,这可能会带来更高效的自动化和更好的人机协作,从而促进人机交互的发展。

推动人工智能的发展:AI模型通过图灵测试的能力可能会推动人工智能技术的发展,促进更多的研究和创新,使人工智能技术更加成熟和普及。

总的来说,AI模型通过图灵测试的重要意义在于证明人工智能的智能水平、提高自然语言处理的质量、促进人机交互的发展以及推动人工智能技术的发展。

02 图灵测试局限性?

该测试只测量了机器模仿人类对话回应的能力,但并不一定表明机器具有真正的智能或理解能力。

该测试严重依赖于人类评估者对机器回应的判断能力,这可能存在主观性和误差。

该测试没有考虑到智能的其他方面,例如创造力、问题解决能力和情感智能。

该测试假定智能仅基于语言和沟通,但还有其他形式的智能无法被该测试捕捉。

该测试受到当前技术水平的限制,可能不是未来人工智能进展的可靠指标。

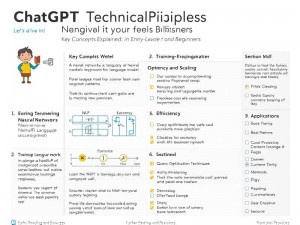

深度学习:深度学习是人工智能的一个子领域,使用神经网络从大型数据集中学习。这种方法使得人工智能系统能够在图像和语音识别、自然语言处理和游戏玩法等任务中实现人类水平的表现。

强化学习:强化学习是一种机器学习类型,重点是训练人工智能代理根据奖励和惩罚做出决策。这种方法使得人工智能系统能够在游戏和其他动态环境中学习复杂的行为和策略。

生成模型:生成模型是人工智能系统,其训练目的是生成与一组训练数据相似的新数据。这种方法使得人工智能系统能够生成类似于人类创建的逼真图片、视频和音频。

迁移学习:迁移学习是一种技术,允许人工智能系统将从一个任务中获得的知识应用到另一个任务中。这种方法使得人工智能系统能够在更少的训练数据下学习新任务,使其更高效和适应性强。

可解释的人工智能:可解释的人工智能是一个新兴领域,重点是开发能够向人类解释其决策和行动的人工智能系统。这种方法有可能增加人工智能系统的透明度和可信度,使其更易于理解和信任。

总的来说,这些人工智能方面的进展使我们更接近复制人类智能,使人工智能系统能够执行复杂的任务,这些任务以前被认为是人类智能的专属领域。虽然还有很多工作要做,但这些进展代表了朝着实现这个目标的重大进展。

02 同时也可能会产生一些潜在的严重的后果:

歧视和偏见:不道德的人工智能系统可能会持续甚至加剧偏见和歧视。这可能会导致对某些人群的不公正待遇,并延续系统性的不平等。

隐私侵犯:没有考虑隐私的人工智能系统可能会导致个人隐私的侵犯。这可能包括未经知情同意收集和使用个人数据,或以侵犯个人权利的方式使用数据。

误导和虚假信息:不道德的人工智能系统可能会促进误导和虚假信息的传播。这可能会产生严重后果,如破坏民主进程或加剧社会分裂。

工作替代:没有考虑劳动力市场影响的人工智能系统可能会导致工作替代和经济混乱,特别是在重度依赖人力的行业。

意外后果:人工智能系统非常复杂,很难理解。如果没有谨慎考虑和审慎开发,它们可能会产生无法预测或控制的意外后果。

我们在开发和应用人工智能需要考虑多个方面,包括数据隐私和安全、透明度和可解释性、社会和伦理问题、数据偏见和公平性。

公正性:人工智能系统应被设计为公正的,并避免延续偏见和歧视。这意味着要确保用于训练人工智能模型的数据具有代表性,并且系统不会不公平地优待或劣待某些群体。

透明度:人工智能系统应该是透明的,意味着它们的决策过程应该对人类可理解和解释。这可以帮助建立对人工智能系统的信任,并确保它们以负责任的方式使用。

隐私权:人工智能系统应该被设计为具有隐私保护意识,这意味着它们应该只收集和使用必要的数据,并获得知情同意。这可以帮助保护个人权利,并防止个人数据被滥用。

问责制:人工智能系统应该被设计为具有问责制,这意味着个人和组织应该对系统造成的任何伤害负责。这可以帮助确保人工智能系统以负责任和道德的方式使用。

安全性:人工智能系统应该被设计为安全的,以防止对人类和环境造成伤害。这意味着需要采取适当的措施确保系统安全,并防止它们被用于可能造成伤害的方式。

社会责任:人工智能系统应该以有助于社会责任和公共利益的方式开发和部署。这意味着需要考虑人工智能的更广泛社会影响,并努力确保技术被用于使所有社会成员受益的方式。

这些问题需要充分的重视和解决,以确保开发出的应用程序是安全、公平、可信任和高效的。

*文章编译来源,

https://openai.com/ ChatGPT, DALL-E,

https://inopen.ai/ research projects and use cases

https://www.bing.com/

https://developer.microsoft.com/en-us/microsoft-365/dev-program

AI Research & Investment Focuses on OpenAI.com